AI的显卡是什么?如何选择适合AI计算的显卡?

- 电子常识

- 2025-07-26

- 4

- 更新:2025-07-20 20:00:17

在深度学习、机器学习以及各种AI应用日益普及的今天,选择合适的硬件设备是提高运算效率的关键。显卡(GPU)作为AI计算的重要组成部分,扮演着至关重要的角色。本文将带您深入了解AI显卡的本质,并提供一系列实用的指导原则,帮助您在面对琳琅满目的显卡产品时,做出明智的选择。

什么是AI的显卡?

AI显卡通常指的是专为执行机器学习算法设计的图形处理单元(GPU)。与传统用于游戏和图形渲染的GPU不同,AI显卡需要处理大量并行计算,因此它们在硬件架构上进行了专门的优化。

在AI计算中,GPU能够同时处理成千上万个线程,这使得它在执行深度学习中的矩阵运算等复杂任务时,相比于CPU具有显著的速度优势。当前,NVIDIA的CUDA架构和AMD的ROCm平台是主要的AI计算平台。

如何选择适合AI计算的显卡?

了解自己的需求

选择AI显卡的第一步,是要明确自己的计算需求。这包括但不限于以下几个方面:

计算规模:您是进行小规模的实验研究,还是需要执行大型的数据分析和模型训练?

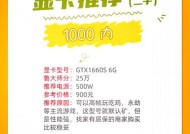

预算范围:您的预算限制是多少?高性能显卡往往价格不菲。

未来扩展性:是否考虑未来升级,或者需要支持多个显卡并行工作?

关注核心参数

在挑选显卡时,应该关注以下几个关键参数:

CUDA核心数:CUDA核心数多意味着并行处理能力强,适合AI运算。

显存大小:足够大的显存能够处理更大规模的数据集和模型,避免频繁的内存交换。

内存带宽:更高的内存带宽可以更快地读写数据,减少等待时间。

功耗和散热:高性能的显卡通常功耗较大,需要良好的散热系统。

兼容性和扩展性:显卡是否与您的系统兼容,以及是否能够方便地进行升级。

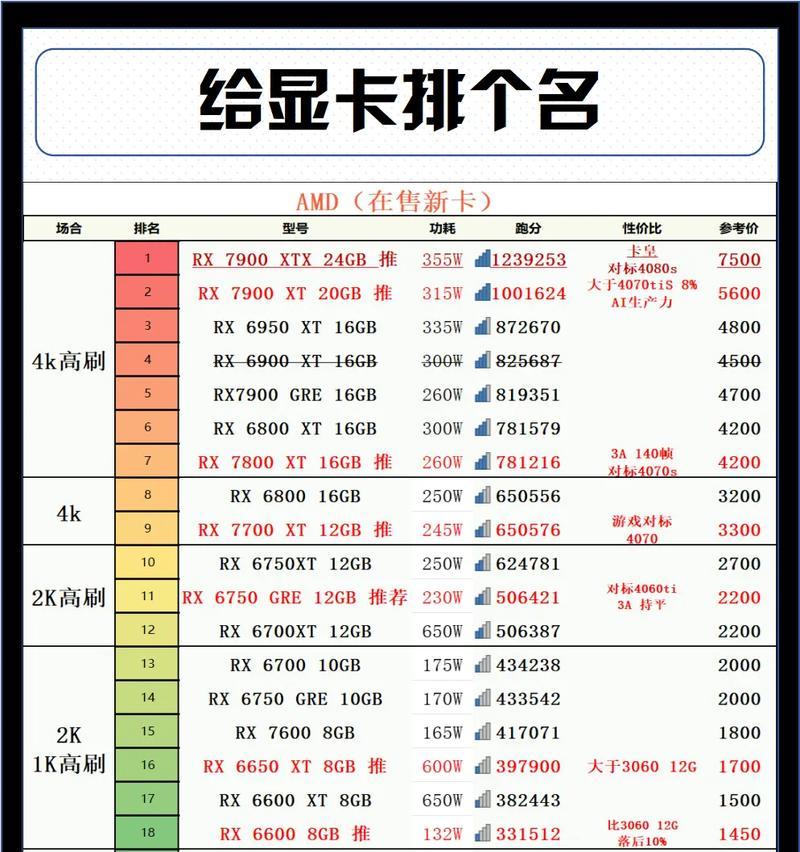

比较品牌与型号

当前市场上,NVIDIA的Tesla和RTX系列、AMD的RadeonInstinct系列显卡是AI计算中的主流选择。每个品牌都提供不同性能和价格的多个型号,您应该根据上述参数和自己的需求进行比较:

NVIDIA:其CUDA架构优化了深度学习计算,RTX系列显卡还支持TensorCores,专门用于加速AI计算。

AMD:其ROCm平台支持OpenCL,虽然在AI领域不如CUDA普及,但在某些应用场景下也有很好的表现。

了解软件兼容性

确保您选择的显卡与您使用的深度学习框架(如TensorFlow、PyTorch)兼容,并且能够获得最新的驱动更新和支持。

考虑售后服务与社区支持

选择有良好售后服务和活跃社区支持的品牌,这将为您的使用和问题解决提供很大帮助。

实用技巧与建议

并行计算与扩展:在资源允许的情况下,使用多个显卡进行并行计算可以显著提高效率。

服务器与工作站的选择:通常AI训练在服务器上进行,而模型的部署和测试则可以利用工作站完成。

云服务的利用:如果预算有限,可以考虑使用云计算服务,按需租用高性能的GPU资源。

结语

选择适合AI计算的显卡是一个需要综合考量多方面因素的决策过程。了解自己的需求,关注关键参数,比较不同品牌和型号,并考虑软件兼容性和售后服务,这些都是做出明智选择的重要步骤。随着技术的不断发展,更多优秀的显卡产品将涌现,为AI计算带来更加高效和便捷的体验。